昆仑万维宣布开源2千亿稀疏大模型Skywork-MoE,该模型是基于Skywork-13B模型中间checkpoint扩展而来,是首个完整将MoE Upcycling技术应用并落地的开源千亿MoE大模型,也是首个支持用单台RTX 4090服务器(8张RTX 4090显卡)推理的开源千亿MoE大模型。

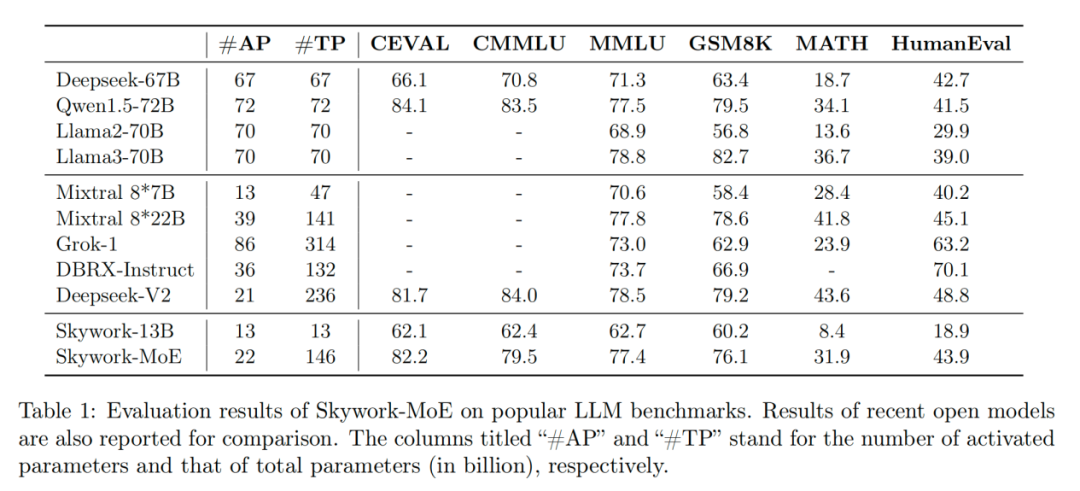

Skywork-MoE模型是天工3.0研发模型系列中的中档大小模型,总参数量为146B,激活参数量22B,共有16个Expert,每个Expert大小为13B,每次激活其中的2个Expert。

此外,天工3.0还训练了75B和400B两档MoE模型,但不在此次开源之列。官方测试显示,在相同的激活参数量20B下,Skywork-MoE能力接近70B的Dense模型,使得模型的推理成本有近3倍的下降。同时,Skywork-MoE的总参数大小比DeepSeekV2的总参数大小要小1/3,用更小的参数规模做到了相近的能力。

技术报告:

https://github.com/SkyworkAI/Skywork-MoE/blob/main/skywork-moe-tech-report.pdf

开源地址:

https://github.com/SkyworkAI/Skywork-MoE

https://huggingface.co/Skywork/Skywork-MoE-Base

本站文章通过互联网转载或者由本站编辑人员搜集整理发布,如有侵权,请联系本站删除。